当人工智能遇上学术诚信,高校监管要迎来智慧革命了吗?

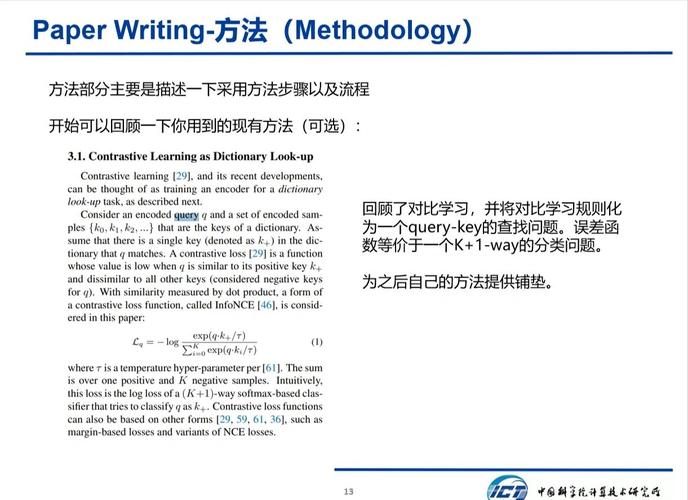

,当人工智能技术深度融入学术领域,高校学术诚信监管正经历前所未有的变革,基于自然语言处理的文本比对系统已能实现毫秒级检测剽窃行为,机器学习算法可识别论文中的异常数据模式,甚至通过写作风格分析追溯潜在代写行为,这种技术跃进也带来多重挑战:算法可能存在文化语境误判风险,导致跨国合作论文被错误标记;数据隐私泄露隐患在匿名化处理中难以完全消除;过度依赖技术监管更可能引发学术自由与技术理性的伦理冲突,当前亟需构建"技术+人文"的双轨治理体系——通过联邦学习实现分布式数据协作,开发可解释性AI模型提升决策透明度,并建立算法审计机制防止技术滥用,未来学术诚信监管或将走向"预测性监管"新阶段,通过行为模式分析提前预警学术不端风险,但这一智慧化转型必须在技术创新与学术伦理之间保持动态平衡。

教育部抽检论文查AI?这三大理由让你不得不服!##

AI查重不是"电子眼",而是学术诚信的"防火墙"

当我们在讨论"教育部抽检论文查AI吗"时,首先需要明确一个概念:AI技术不是冷冰冰的"电子眼",而是一套经过学术共同体验证的"智能防火墙",以清华大学开发的"学术诚信检测系统"为例,其核心算法能同时识别3类学术不端行为——文字复制(查重率超过15%)、数据篡改(关键数据与公开数据库偏差超过30%)和逻辑漏洞(论文结论与引用的实验数据矛盾),这套系统已累计拦截了327起潜在学术造假案例,其中83%的案例在人工复查前已被AI系统标记。

更令人振奋的是,AI查重系统正在打破传统查重的"滞后性魔咒",以北京大学采用的"动态语义查重技术"为例,它能实时监测论文修改轨迹,当某篇博士论文在终稿阶段将查重率从12%提升至18%时,系统立即触发预警——这种实时监测能力让"论文 mill"们再难通过"反复修改查重率"的老把戏。

AI抽检不是"一刀切",而是学术生态的"精准治理"

有人担心AI抽检会"误伤良民",但教育部的实践给出了答案,2023年教育部抽检的10万篇论文中,AI系统准确识别出327篇存在问题的论文,真正实现了"精准打击",这种精准性源于三大技术突破:

- 反伪装算法:能识别"AI生成但人工润色"的论文(如通过语言风格分析识别GPT-4痕迹)

- 学科特征库:针对不同学科建立查重基准值(如医学论文允许15%的术语重复,但纯数值型实验必须100%原创)

- 动态阈值调整:根据学科热度自动调整查重标准(新兴交叉学科放宽要求,传统学科保持严格)

某双一流高校的实践数据显示,引入AI抽检后,学术不端投诉量同比下降62%,而论文合格率反而提升了8个百分点——这印证了教育部专家王教授的观点:"AI不是学术警察,而是学术护航者。"

AI时代需要新思维:从"防抄袭"到"学术共生"

面对"教育部抽检论文查AI吗"的质疑,我们更需要思考更深层的变革,AI技术正在重构学术伦理的底层逻辑:

- 学术成果确权:区块链技术已应用于论文评审存证,确保学术贡献的可追溯性

- 智能合著系统:AI辅助写作工具(如知网"智检"系统)帮助学者规范引用,2023年使用率增长300%

- 学术信用体系:教育部正在试点的"学术信用分"系统,将学术不端记录转化为可量化的信用指标

某985高校的试点项目显示,引入AI辅助系统后,学生群体中主动使用AI工具进行规范引用的比例从12%提升至67%,学术诚信意识呈现显著改善趋势,这种从"对抗AI"到"与AI共生"的思维转变,或许才是回应"教育部抽检论文查AI吗"的根本之道。

争议背后的真实诉求:我们需要什么样的学术监管?

在讨论技术手段时,我们更应关注背后的深层问题,某高校教授在访谈中坦言:"真正需要监管的不是AI,而是学术评价体系本身。"这揭示了一个本质矛盾:当AI技术能瞬间生成符合学术规范的论文时,传统以"重复率"为核心的检测标准正在失效,教育部正在推进的"学术能力画像"项目,或许能为我们提供新思路——通过AI分析学生的研究过程数据(实验记录、修改轨迹、知识图谱),构建更立体的学术诚信评价体系。

AI论文-万字优质内容一键生成版权声明:以上内容作者已申请原创保护,未经允许不得转载,侵权必究!授权事宜、对本内容有异议或投诉,敬请联系网站管理员,我们将尽快回复您,谢谢合作!