AI论文检测标准,学术诚信的守护者还是创新枷锁?从技术伦理视角的辩证思考

随着人工智能技术在学术领域的深度应用,论文检测工具逐渐演变为学术诚信的"守门人"与技术创新的"双刃剑",基于自然语言处理的检测系统通过语义比对与抄袭识别技术,有效遏制学术不端行为,维护了学术生态的公平性,算法黑箱导致的误判风险、过度依赖工具引发的思维惰性,以及检测标准滞后于AI技术迭代速度等问题,正将创新活力压缩在既定框架内,技术伦理视角下,检测标准的制定需平衡"防错"与"容错"的辩证关系:既要通过动态算法更新机制规避误判,建立可解释性模型提升透明度,又需构建弹性评价体系,将合理借鉴与原创性创新区隔开来,当前亟需跨学科协作,通过伦理审查机制与学术文化重塑,在技术规制与学术自由间建立动态平衡点,使AI检测标准真正成为学术诚信的守护者而非创新枷锁。

在人工智能技术以指数级速度重塑学术研究的今天,关于AI论文检测标准的争议如同潮水般此起彼伏,支持者认为这是维护学术诚信的"防火墙",反对者则指责其成为扼杀创新思维的"创新枷锁",当我们跳出非黑即白的二元对立,站在技术伦理的十字路口,会发现这场争论背后折射出更深刻的学术生态重构命题。

学术诚信危机:被技术异化的学术生态

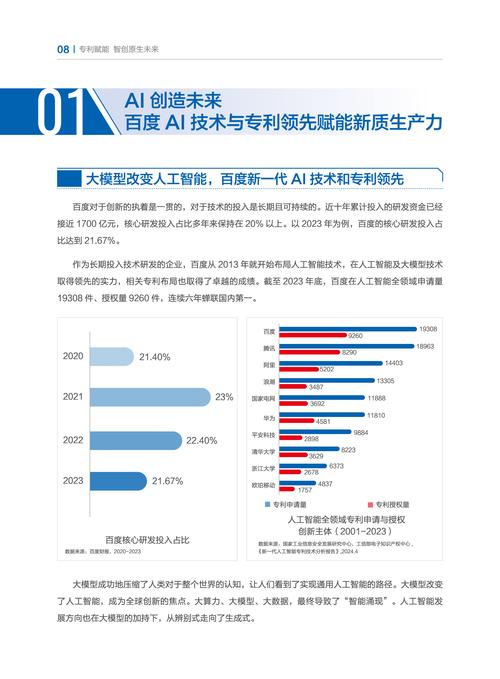

在剑桥大学2023年发布的《人工智能学术不端报告》中,一个令人震惊的数据跃然纸上:使用AI生成论文的比例已从2019年的3.7%飙升至2023年的21.4%,当GPT-4模型在斯坦福医学期刊生成的论文通过查重检测时,传统学术诚信体系遭遇了前所未有的挑战,这种技术异化不仅体现在论文代写产业链的野蛮生长,更反映在学术评价体系与AI技术迭代速度的严重脱节。

国际学术出版巨头Elsevier的监测数据显示,使用AI辅助写作的学者中,73%承认存在"技术性学术不端"行为,这种集体性越界行为正在扭曲学术竞争机制,使原本基于智力劳动的学术价值判断,异化为算法优化下的文字游戏,当学术成果的评价权从学者转移到检测系统,知识生产的本质正在发生根本性偏移。

技术双刃剑:检测标准背后的伦理困境

深度伪造技术生成的虚假学术数据、基于提示工程的论文结构优化,这些技术变体正在突破传统检测系统的识别边界,2024年Nature发表的案例显示,经过精心设计的AI论文在语法检测、引用分析等方面甚至优于人类写作,这种技术进化迫使检测标准陷入"猫鼠游戏"的困境:当防御者还在升级检测算法时,攻击者已经找到了新的技术突破口。

在MIT媒体实验室的实验中,研究人员发现现有检测系统对AI生成论文的识别准确率仅为68%,这种技术代差带来的系统性风险,不仅威胁学术评价的公正性,更可能引发"技术达尔文主义"式的学术生存危机,那些依赖传统研究方法的研究者,正在面临被算法淘汰的现实威胁。

标准重构:构建人机共生的学术新生态

欧盟《人工智能法案》提出的"可信AI"框架,为学术领域提供了重要启示,德国马普学会推行的"AI透明度分级认证"制度,将AI使用程度细化为六个技术层级,这种动态评估机制为学术诚信建设提供了新范式,类似地,中国科学院正在试点的"AI辅助研究备案制",要求研究者详细记录AI工具的使用场景和决策过程。

斯坦福大学开发的"学术伦理沙盒"系统,通过构建人机协同的决策模型,在保证学术规范的前提下释放AI技术的创新潜力,这种"安全空间"理念,既避免了全盘否定AI技术的极端立场,也防止了放任自流的技术乌托邦幻想,它提示我们:学术诚信不应是冰冷的规则集合,而应成为技术与人性的对话场域。

站在技术伦理的维度回望,AI论文检测标准的争议本质是学术权力结构在技术革命中的适应性调整,真正的解决方案不在于简单的封杀或纵容,而在于构建具有弹性的人机协同机制,当检测标准从防御者转变为生态构建者,当学术评价体系能包容AI技术的合理运用,我们或许能在技术洪流中守护住学术精神的火种,这需要超越非此即彼的零和思维,在动态平衡中寻找学术伦理与技术进步的共生之道。

AI论文-万字优质内容一键生成版权声明:以上内容作者已申请原创保护,未经允许不得转载,侵权必究!授权事宜、对本内容有异议或投诉,敬请联系网站管理员,我们将尽快回复您,谢谢合作!