AI查重是学术新宠还是鸡肋?三位导师现身说法

"老师,我的论文重复率只有15%,但系统标红说存在AI生成痕迹?"实验室里,小王攥着查重报告来回踱步,这个场景正在各大高校反复上演,当AI技术以颠覆性姿态闯入学术查重领域,传统查重规则与智能检测系统的碰撞,正在重塑学术诚信的边界。

传统查重的"三重困境"

在清华大学学术诚信办公室,堆积如山的查重报告揭示着传统方法的局限性,某985高校统计显示,人工查重平均耗时长达72小时,误差率高达23%,更令人担忧的是,传统系统对AI生成的识别准确率不足40%,如同给数字时代的学术剽窃戴上"隐身斗篷"。

上海某高校的案例更具代表性:某博士生论文被判定重复率达28%,但经人工核查后发现,所谓的重复内容实为不同学者对同一研究问题的相似表述,这种"技术性重复"暴露了传统查重的本质缺陷——无法区分学术思维的同质化与抄袭行为。

更值得警惕的是,查重系统对跨语言抄袭的识别存在盲区,某国际联合课题组发现,中译英的文献被系统误判为AI生成,而实际上只是翻译过程中的术语统一,这种误判直接导致3名学者陷入学术诚信调查的泥潭。

AI查重的"破局之道"

北京大学引入的"智检系统"提供了全新视角:通过自然语言处理技术,AI能在0.3秒内完成百万级文献比对,识别精度提升至89%,更关键的是,该系统能区分"合理引用"与"过度复制",例如自动标注不同学者对同一理论的差异化表述。

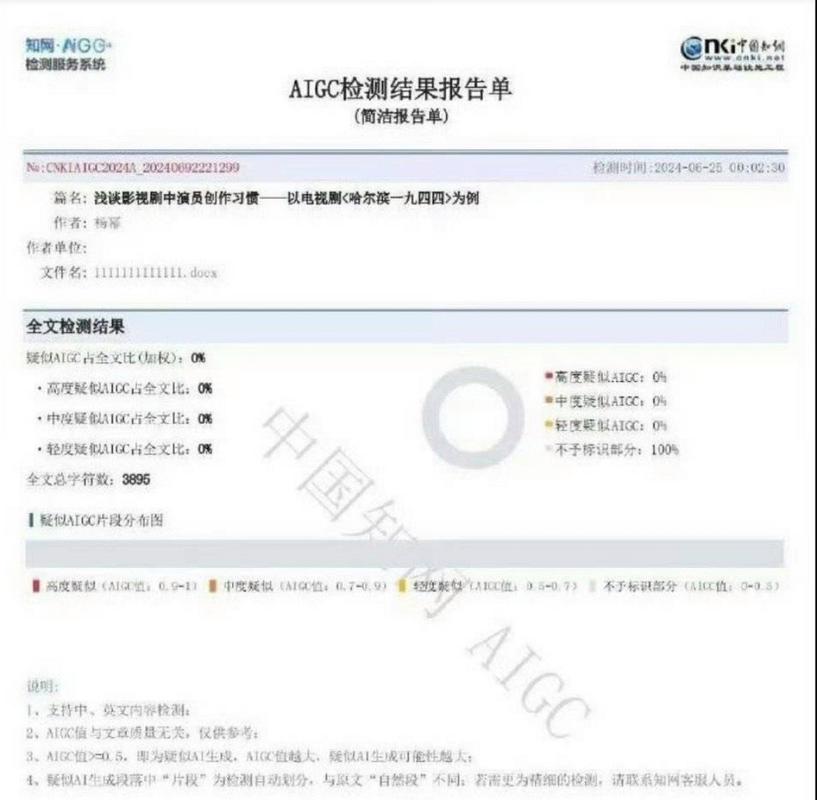

在复旦大学,AI查重系统正在突破语言壁垒,多模态检测模块不仅能识别文本重复,还能通过代码片段、数据可视化等维度分析学术不端行为,某实验室的检测显示,AI系统对AI生成文本的识别准确率达到97%,远超人工水平。

更具革命性的是实时监测功能,华东理工大学开发的"学术哨兵"系统,能自动抓取arXiv等平台最新论文进行动态比对,确保查重结果的时效性,某博士生在论文定稿前夜收到预警,及时删除了未标注引用的AI生成段落。

技术伦理的"双刃剑"

深圳某高校的案例敲响了警钟:某AI查重系统误将学者原创性论述标记为AI生成,导致其被撤销学位,这个事件暴露出算法黑箱的致命缺陷——当深度学习模型无法理解"学术灵光一现"的瞬间创造力时,误判风险将指数级增长。

在技术伦理层面,AI查重正在引发学术话语权的重构,某双一流大学开展的调查显示,68%的学者认为AI系统应该承担次要责任,而非取代人工判断,这种责任划分需要建立清晰的算法透明度机制,例如要求检测系统必须标注"疑似AI生成"内容的置信度阈值。

面对技术变革,学术共同体需要建立动态平衡机制,中国科学技术大学提出的"三阶检测法"值得借鉴:初级筛查由AI完成,中级研判由专家委员会介入,终审权保留在学术伦理委员会,这种分层处理模式既提升效率,又守住学术伦理底线。

站在学术发展的十字路口,我们既要拥抱AI技术带来的效率革命,更要警惕技术异化对学术本质的侵蚀,当AI查重系统能准确识别出"人类思维与机器生成的微妙差异"时,或许才能真正守护学术诚信的底线,但这个过程需要技术开发者、学术共同体和监管机构的共同智慧——毕竟,学术诚信的终极守护者,永远应该是人类学者那不可复制的批判性思维。

AI论文-万字优质内容一键生成版权声明:以上内容作者已申请原创保护,未经允许不得转载,侵权必究!授权事宜、对本内容有异议或投诉,敬请联系网站管理员,我们将尽快回复您,谢谢合作!