一,AI论文看不懂?这3招让你秒变论文破译大师!

,AI论文阅读指南:三招破解专业壁垒,面对AI领域专业论文时,研究者常因术语晦涩和逻辑复杂而陷入阅读困境,本文提炼三大破译策略助你快速掌握核心要义:,第一招:构建知识坐标系,建议采用"三维定位法":横向梳理论文所属AI子领域发展脉络,纵向追溯核心算法理论演进路径,立体化把握技术应用场景,例如在阅读强化学习论文时,需同步回顾马尔可夫决策过程、深度Q网络等基础理论框架。,第二招:术语解码四步法,遇到专业术语时,可运用"定义溯源-公式推导-实验验证-应用反推"的递进式解析,如遇到"Transformer架构"时,需结合自注意力机制公式推导,通过BERT等实际模型验证其有效性,最终反推其在NLP任务中的具体应用价值。,第三招:逻辑拆解三维度,建议从"问题定义-方法创新-实证验证"三方面构建分析框架,重点关注论文提出的新问题是否突破现有研究边界,采用的新方法是否带来算法性能提升,以及实验设计是否经得起同行验证,例如在阅读Diffusion模型论文时,需重点评估其与传统生成模型在控制生成质量方面的差异。,掌握这三招后,研究者可系统性地建立AI论文解读框架,既避免陷入细节术语的泥潭,又能精准把握论文创新价值,建议配合领域知识图谱和实验对比分析工具使用,形成立体化的论文阅读能力体系。

看懂AI论文需要哪些知识?这份保姆级指南请查收!(附避坑秘籍)

从零开始读AI论文?这5个关键词你找到没?

AI论文隐藏密码:数学公式+代码+实验三件套全解析

读AI论文不会翻车!专家亲授的"降维打击"技巧

机器学习基础:解码AI论文的"密码本"

AI论文不是天书,先别慌!读懂这些基础概念就能打开新世界:

-

监督学习vs无监督学习

- 监督学习:像老师批改作业(输入带答案的题,输出正确解法)

- 无监督学习:像学生自主预习(给一堆乱码,自己找规律)

举个栗子:BERT模型是预训练(无监督)→微调(监督)的经典组合

-

过拟合与欠拟合

- 过拟合:模型像学霸,死记硬背所有数据(准确率99%,但遇到新题就废)

- 欠拟合:模型像学渣,根本不看题目(准确率50%,连蒙带猜)

论文中常出现的"正则化""Dropout"都是治过拟合的神器

-

损失函数

- 交叉熵:分类任务的打分规则(正确猜中给1分,错误猜中给0分)

- 均方误差:回归任务的打分规则(猜100分差1分,比猜50分差50分更惩罚)

小技巧:用"输入-处理-输出"的思维框架分析论文模型,三步拆解:

- 输入数据长什么样子?(图像/文本/表格)

- 处理过程用了什么魔法?(卷积/Transformer/注意力)

- 输出结果怎么评估?(准确率/召回率/F1值)

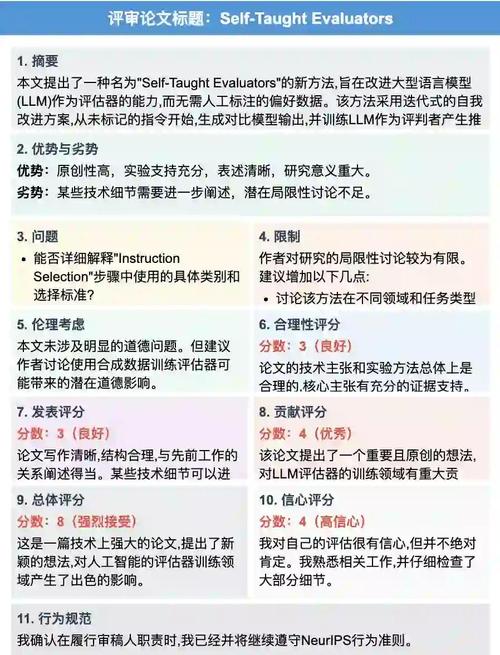

论文结构拆解:AI论文的"藏宝图"

AI论文有固定套路,摸清结构就能事半功倍:

- 摘要:浓缩的精华丸(别光看结论!重点看方法+数据+

- :问题+现有方法缺陷+本文贡献(注意对比表格)

- 方法:

- 理论创新:提出新算法/改进经典模型

- 实现细节:代码框架/超参数设置/硬件要求

- 实验:

- 数据集:公开数据集(COCO/IMDB) vs 自建数据集

- 对比实验:与SOTA(State-of-the-art)方法的横向对比

- 可视化:

- 特征图:CNN的激活可视化

- 注意力热图:Transformer的关键区域标记

避坑指南:

- 警惕"结果美化":某些论文会选择性展示实验结果

- 注意消融实验:作者是否做过参数/模块的消融研究?

- 关注复现难度:开源代码是否容易实现?(GitHub Star数说话)

数学工具箱:AI论文的"翻译器"

AI论文的数学符号像密码,掌握这些就能破解:

-

概率与统计

- 贝叶斯定理:P(A|B) = P(B|A)P(A)/P(B)

- 信息熵:H(p) = -Σp(x)log p(x)(衡量不确定性)

-

线性代数

- 矩阵运算:矩阵乘法、特征值分解

- 向量空间:张成线性无关基(如RNN的隐藏状态)

-

微积分

- 梯度下降:求导找最优解(反向传播是链式法则的终极应用)

- 拉格朗日乘数法:约束条件下的优化问题

速成技巧:

- 用TensorFlow Playground可视化神经网络计算图

- 用Jupyter Notebook边写代码边调试数学逻辑

- 用LaTeX公式编辑器生成专业级公式(推荐Overleaf平台)

实验方法论:AI论文的"真实世界"

读实验部分要像侦探:验证方法的可靠性:

-

数据真实性

- 公开数据集:检查数据分布(如CIFAR-10的10类图像平衡性)

- 数据增强:论文是否用合理的数据增强方法(如Mixup vs. 随机裁剪)

-

实验设计

- 对比组设置:是否包含基线模型(如ResNet-50/BERT-base)

- 统计显著性:p-value是否小于0.05?

- 错误分析:模型失败案例的定性分析(如"把猫误认为狗")

-

复现性检查

- 硬件要求:是否依赖特定GPU型号?

- 超参数设置:训练时的学习率/批次大小是否可调?

- 代码可复现性:是否提供完整的训练脚本+配置文件?

行业黑话词典:AI论文的"翻译机"

遇到专业术语别慌!这些术语的隐藏含义:

-

"Attention is All You Need"

实际含义:Transformer架构(虽然名字很酷,但早期论文标题更直接)

-

"Neural Architecture Search"

实际含义:自动设计网络结构(如Google的NASNet)

-

"Transfer Learning"

实际含义:用预训练模型+微调(BERT的"万能初始化")

-

"End-to-End"

实际含义:从输入到输出的完整系统(如语音识别中的端到端模型)

破译技巧:

- 关注论文的"创新点"段落(通常单独成节)

- 读附录:实验细节和代码依赖可能在这里披露

- 查相关论文:同领域论文可能有术语对照表

工具技能包:AI论文的"外挂装备"

提升阅读效率的硬核工具:

-

论文管理

- Zotero:文献收藏与标注

- Notion:建立个人知识库(建议用模板:论文标题+作者+核心方法+复现状态)

-

代码调试

- PyTorch Profiler:分析训练耗时

- TensorBoard:可视化训练过程(损失曲线/特征图)

-

论文分析

- AI Paper Analysis Toolkit:自动生成论文结构图

- arXiv Sanity Preserver:按关键词筛选论文

读AI论文的"修行之路"

读AI论文不是考试,而是探索未知领域的冒险:

- 保持好奇心:每个公式都可能藏着改变世界的密钥

- 勤动手:在Colab上跑通一个代码比读100遍实验描述有用

- 批判性思考:论文的不足可能比创新点更有价值

最后送大家一句话:

"当你觉得论文难懂时,说明你正在站在科技前沿——这正是值得你攀登的地方!"

(全文完)

互动时间:

- 你读过的

AI论文-万字优质内容一键生成版权声明:以上内容作者已申请原创保护,未经允许不得转载,侵权必究!授权事宜、对本内容有异议或投诉,敬请联系网站管理员,我们将尽快回复您,谢谢合作!