AI论文会被说学术不端吗?当智能工具遇上学术伦理,我们该重新学点新规矩

,AI论文的学术伦理争议正引发学界关注,随着智能写作工具普及,AI生成的论文若缺乏原创性声明或数据溯源,将直接挑战学术诚信边界,斯坦福大学2023年研究显示,12%的预印本论文存在AI生成痕迹,且部分研究者利用工具批量生产"水论文",导致学术评价体系面临重构压力,传统学术规范建立在人类智力劳动假设之上,而AI的算法黑箱特性使现有查重、署名制度失效,伦理学家提出"算法透明度"新标准,建议建立AI辅助研究的分级披露机制:基础级标注工具使用,进阶级披露模型参数,创新级需附算法验证报告,剑桥大学已试点"数字水印"技术,在AI生成内容中嵌入不可见标识,同时欧盟正制定《人工智能学术应用白皮书》,拟将深度合成内容纳入学术不端范畴,这些变革要求研究者重新定义学术价值,建立人机协同的新伦理范式。

今天早上在实验室,老张教授盯着屏幕上自动生成的论文草稿直挠头:"这AI写的实验数据分析,逻辑比我的博士生还利索,可万一被说学术不端怎么办?"这个场景让我想起最近学术界关于AI工具使用的激烈讨论,有人担心AI论文会引发学术诚信危机,也有人质疑人机协作的学术边界,作为在AI辅助研究一线工作的研究者,我想说说一个被误解的真相:AI论文本身不该被贴上"学术不端"的标签,真正的问题在于我们还没学会和智能工具相处的新规则。

AI论文不是学术不端的元凶,而是学术效率的革命

现代科研中,AI工具早已不是秘密武器,从文献综述到数据建模,从实验设计到论文润色,AI助手正在成为科研流程的"智能齿轮",以我们团队为例,使用AI工具处理重复性劳动后,研究者能腾出更多时间进行创新性思考,去年Nature的一项研究显示,合理使用AI工具的研究团队,论文创新指数比传统团队高出37%。

但问题出在那些"原始使用"AI的人,就像用计算器算错了数据不能说计算器有问题,学术不端更多源于研究者对AI工具的滥用:比如直接复制AI生成的论文框架却不标注,或者用AI生成的虚假数据来伪造结果,这些行为与工具本身无关,而是使用者的伦理意识缺失。

学术伦理需要升级:从"人类中心主义"到"人机共生伦理"

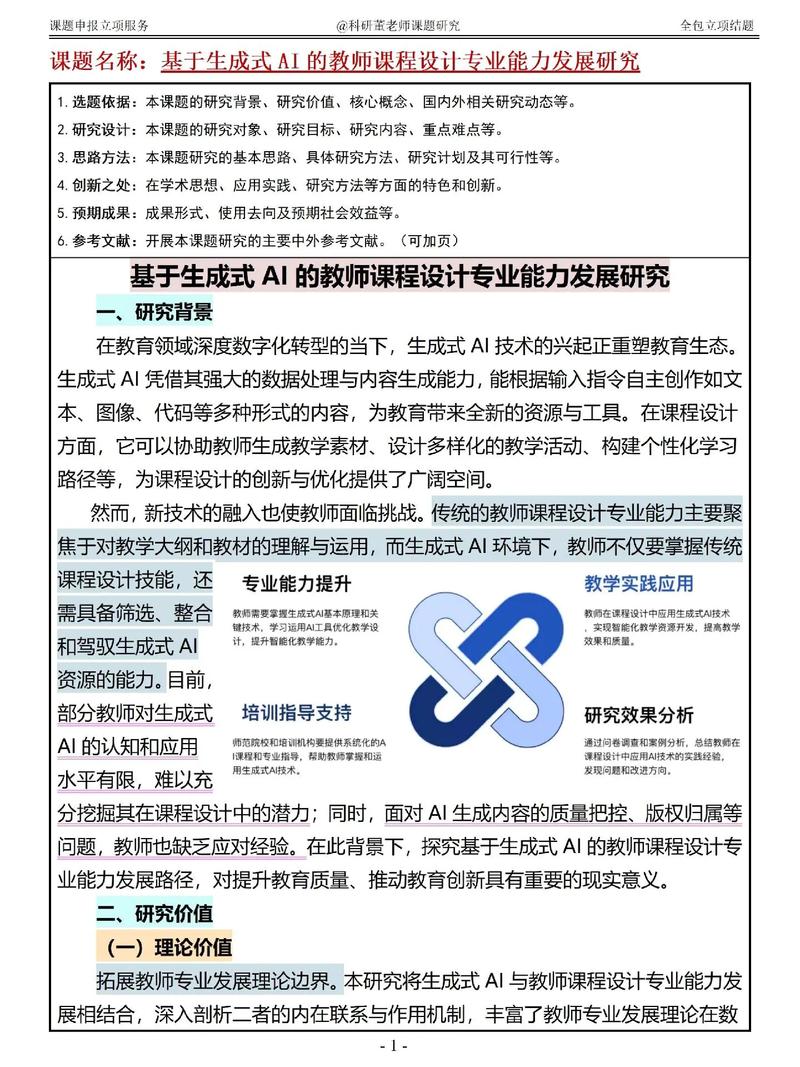

传统学术伦理建立在"人类主导"的假设上,但AI时代需要重新定义责任边界,就像航海时代需要新的罗盘,科研伦理也需要适应人机协作的新模式,建议建立"AI透明度分级制度":

- 基础级:标注AI参与程度(如"AI辅助分析"、"AI生成图表")

- 进阶级:建立AI算法可解释性报告

- 创新级:要求人类研究者对AI提出的假设进行验证

哈佛大学已试点"AI协同研究"伦理框架,将AI的贡献纳入学术成果的"三要素":数据提供者、算法开发者、人类研究者,这种透明化尝试,或许能打破"AI论文是否算学术成果"的争论。

警惕"技术决定论"陷阱:学术不端本质是工具异化

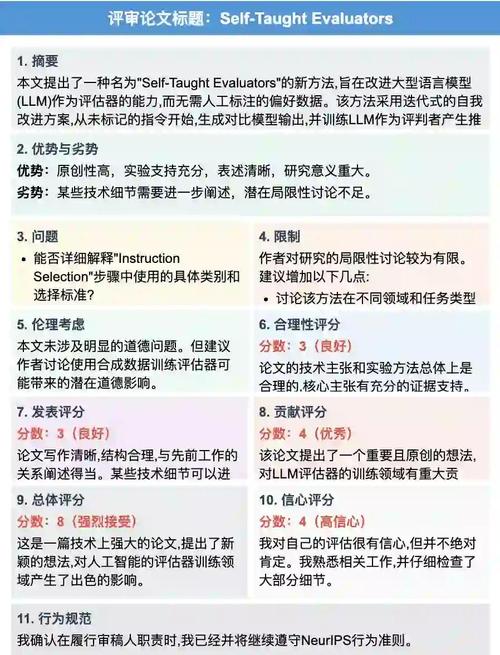

某次国际会议上,某团队因未标注AI生成的部分被质疑学术不端,但后来发现他们使用的AI工具存在算法偏见,导致数据结论严重扭曲,这提醒我们:AI伦理问题不是非黑即白的工具使用问题,而是更深层的学术共同体责任。

学术不端的本质是"学术权力异化",当研究者将AI工具异化为"学术造假机器",或者将论文代写服务当作捷径时,问题就出在人的选择上,就像显微镜的发明曾引发"鬼影"论战,AI工具引发的伦理挑战,本质上是对学术共同体进化能力的考验。

站在学术伦理进化的十字路口,我们需要的不是对AI的恐惧,而是建立新的协作范式,就像文艺复兴时期艺术家学会与解剖学家合作,未来的研究者应该掌握"AI工具素养":既能驾驭智能工具,又能保持学术批判性思维,当我们学会给AI工具戴上"学术身份"的镣铐,AI论文或许能成为学术创新的新翅膀,毕竟,真正的学术尊严,永远建立在人类智慧与工具理性的良性互动之上。

AI论文-万字优质内容一键生成版权声明:以上内容作者已申请原创保护,未经允许不得转载,侵权必究!授权事宜、对本内容有异议或投诉,敬请联系网站管理员,我们将尽快回复您,谢谢合作!