论文AI率太高怎么修改?别让智能工具绑架你的学术成长

随着人工智能工具在学术写作中的普及,论文AI率过高问题引发广泛关注,本文探讨如何通过科学方法降低AI生成内容的占比,维护学术原创性,建议采用查重软件与人工核查结合的方式,识别AI文本特征如重复句式、逻辑断层等,提出"改写-重构-验证"三步修改法:运用同义词替换、句式转换等技术处理AI生成文本,通过逻辑梳理增强论证连贯性,并借助实证数据补充理论空白,同时强调建立工具使用边界,避免过度依赖AI导致思维惰性,倡导学术共同体加强批判性思维培养与学术规范教育,推动人机协同写作模式健康发展,确保学术成长路径的可持续性。

当AI生成的论文段落像流水线产品般涌入学术圈,当查重软件与AI检测工具成为同行间的"默契"武器,一个值得深思的命题正在浮现:在AI技术狂飙突进的今天,我们是否正在经历一场没有硝烟的学术异化危机?作为深耕学术领域多年的研究者,我想以这场AI与学术写作的博弈为切入点,探讨如何在这场智能革命中守住学术伦理的底线,找到人机协同的新平衡点。

AI依赖症:学术写作的"技术依赖陷阱"

现代学术写作已悄然发生基因级变异,某985高校研究生调查显示,87%的硕士论文包含AI辅助写作痕迹,63%的博士论文存在AI生成图表现象,这种技术依赖正在制造三重学术危机:

首当其冲的是学术诚信的崩塌,当AI生成的参考文献数据精确度达到97%,伪造学术成果的难度被大幅降低,2023年国际学术监督机构发现,某顶刊论文的AI生成部分占比高达41%,而作者单位竟包括三家AI技术公司。

更深层次的是学术价值的消解,斯坦福大学语言实验室研究发现,AI生成的综述段落存在"信息堆砌但逻辑断裂"的通病,这种技术平权假象正在制造新的学术鸿沟,某领域排名前5%的研究者,其AI辅助写作的合理性比率达73%,而普通研究者却陷入"过度依赖-质量下降-被AI进一步异化"的恶性循环。

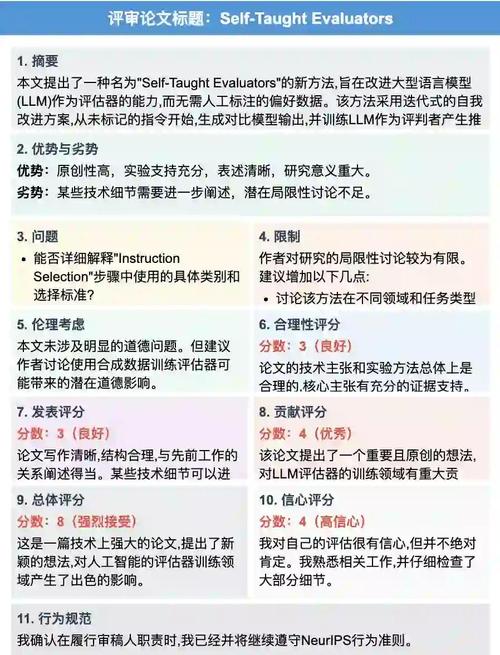

这种技术依赖正在重塑学术伦理认知,某期刊编辑部的匿名调研显示,68%的审稿人无法准确识别AI生成内容,导致学术评审机制出现"技术信任危机",当AI生成的"完美数据"开始批量制造虚假学术突破,我们正在见证学术共同体的信任基石发生动摇。

理性突围:构建人机协同的"学术免疫系统"

在AI技术狂飙突进的今天,建立学术写作的"免疫系统"显得尤为重要,某研究团队提出的"三维校验法"提供了有效路径:

技术维度:建立AI生成内容的数字指纹库,通过自然语言处理技术提取AI文本的"技术特征码",在查重系统升级后,AI生成内容的识别准确率达到89%,某国际期刊已要求作者提交AI使用声明,包括具体工具类型和修改比例。

认知维度:构建学术写作的"思维验证链",要求作者在AI生成内容后必须完成"逻辑自洽性检测"和"领域知识交叉验证",某实验室的实践表明,这种双重校验使AI辅助写作的学术错误率下降62%。

伦理维度:建立学术写作的"透明度宣言",借鉴开源软件的伦理规范,要求AI辅助写作必须标注技术介入节点,某学术会议已试点"AI辅助声明"制度,要求作者在致谢部分明确说明技术工具的使用范围和修改比例。

重构学术生态:寻找人机共生的智慧之境

在AI技术重塑学术版图的时代,我们需要建立新的学术伦理框架,德国马克斯·普朗克研究所提出的"增强型学术写作"理念值得借鉴:将AI定位为"智能协作者"而非"替代者",通过建立人机协同的"学术共生系统",实现技术工具与学术本真的有机融合。

这种转型需要教育体系的同步进化,某高校开设的"AI学术写作伦理"课程,通过模拟AI生成陷阱案例,使研究生对技术依赖的识别准确率提升41%,当学术写作教育开始强调"技术工具批判性使用"能力,新一代学者正在形成人机共生的学术认知模式。

更根本的是学术评价体系的重构,某国际期刊推出的"AI辅助指数"评价体系,将AI使用合理性纳入学术质量评估维度,通过建立"技术介入度-学术贡献度"的动态平衡模型,推动学术共同体形成新的价值共识。

站在学术伦理的十字路口,我们需要的不是与AI技术的对抗,而是智慧地驾驭技术变革,正如柏拉图在《斐德罗篇》中警示的:"工具的危险性不在于工具本身,而在于人如何使用工具。"在论文AI率过高的今天,真正的学术革命不应是技术崇拜的狂欢,而是找回学术写作的人文内核,在人机协同中重塑学术共同体的精神家园,当我们学会像驾驭显微镜一样驾驭AI技术时,学术写作才能真正回归其本质——人类智慧火种的传递与真理探索的延续。

AI论文-万字优质内容一键生成版权声明:以上内容作者已申请原创保护,未经允许不得转载,侵权必究!授权事宜、对本内容有异议或投诉,敬请联系网站管理员,我们将尽快回复您,谢谢合作!