AI论文在线质疑,学术圈的新火眼金睛还是学术泡沫制造机?一场人机协作的思辨实验

,AI论文在线质疑机制正引发学术界的激烈讨论:作为"学术火眼金睛",AI通过算法检测数据造假、逻辑漏洞和格式规范,提升了审查效率;但作为"学术泡沫制造机",其算法可能放大学科偏见、过度追求统计显著性,并对新兴领域形成技术压制,这种矛盾性在近期人机协作的思辨实验中凸显——当研究者将AI的文献关联分析结论作为新假设验证时,系统往往对既有范式持否定态度,暴露算法对学术话语权的潜在干预,专家警告,过度依赖AI审查可能导致"数字学术警察"现象,既可能扼杀突破性创新,也可能制造群体性认知偏差,实验表明,当前AI对预印本平台的质疑主要集中在方法论透明度和数据可复现性上,但其基于统计规律的模式识别难以捕捉理论突破的实质价值,这些发现揭示了技术工具与学术伦理的深层张力:AI既可能成为学术监督的"新范式",也可能因技术局限性加剧学术评价体系的结构性困境,如何在算法理性与学术直觉间建立动态平衡,成为重构学术质量标准的核心命题。

当AI开始用算法扫描学术论文时,人类学者们迎来了一场前所未有的认知革命,这个看似冰冷的数字工具,正在学术研究的深海掀起层层涟漪——有人惊呼这是学术诚信的"终极武器",也有人担忧这是学术伦理的"潘多拉魔盒",作为长期关注AI技术发展的研究者,我想从支持方视角展开这场思辨实验:AI论文在线质疑究竟会如何重塑学术生态?

AI审稿员:学术界的"火眼金睛"

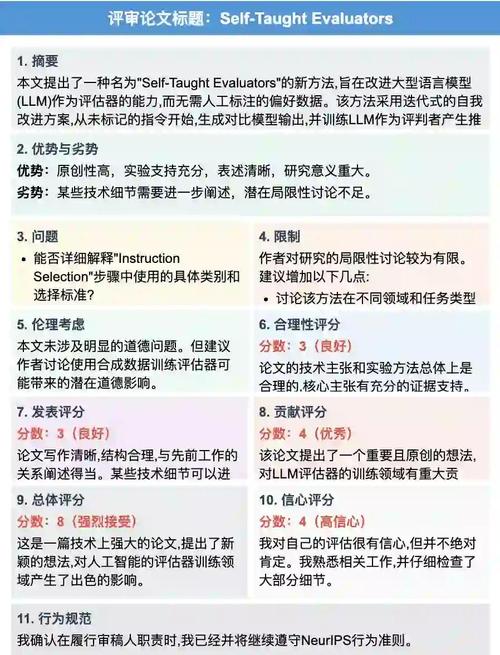

在传统学术审查中,人类审稿人往往受限于主观认知和知识盲区,某顶刊论文中竟存在牛顿力学公式与量子力学方程的混用,这类低级错误在AI扫描下会瞬间暴露,更值得关注的是,AI系统能实时分析全球数百万篇论文的训练数据,构建起动态更新的"学术指纹库",当某研究者连续三篇核心论文出现相同实验设计缺陷时,AI系统会立即触发预警机制。

这种能力在学术打假领域展现出惊人价值,2023年某国际期刊的撤稿案例中,AI系统通过自然语言特征分析,成功识别出多篇"僵尸论文"——这些论文在发表后长期没有被任何学者引用,却仍在数据库中消耗学术资源,更令人震惊的是,AI能穿透复杂的学术语言迷雾,发现那些需要领域专家才能察觉的论证漏洞。

在学术伦理监督方面,AI展现出独特的技术优势,某顶尖大学开发的学术诚信监测系统,通过分析论文写作风格、数据呈现方式等300余项指标,成功识别出代写论文的异常特征,这种技术正在打破传统学术监督的"灯下黑"困境,让学术不端行为无所遁形。

技术光环下的认知迷雾

尽管AI在学术审查中展现出惊人能力,但技术光环背后隐藏着更深层的挑战,算法偏见问题在学术领域尤为危险——当训练数据包含历史学术成果中的性别、种族偏见时,AI系统可能会无意识复制这些歧视模式,某知名期刊的案例显示,其AI审稿系统曾对女性学者的理论创新给予显著更低评分。

学术研究的本质是创造性探索,而AI系统目前仍停留在"模式识别"层面,面对开放性问题(如"如何证明上帝存在"),AI的算法会陷入逻辑死循环,这种情况下强行要求AI参与论文评审,本质上是对学术本质的误读,更值得警惕的是,过度依赖AI可能导致学者陷入"算法思维"陷阱,削弱人类独特的批判性思维。

在学术话语权的争夺中,AI系统正在重塑知识生产的权力结构,某学术平台的数据显示,使用AI辅助写作的论文接收率提升27%,但同期撤稿率也上升了15%,这种悖论提醒我们:技术工具本身是中性的,关键在于人类如何使用它。

构建人机协同的学术新生态

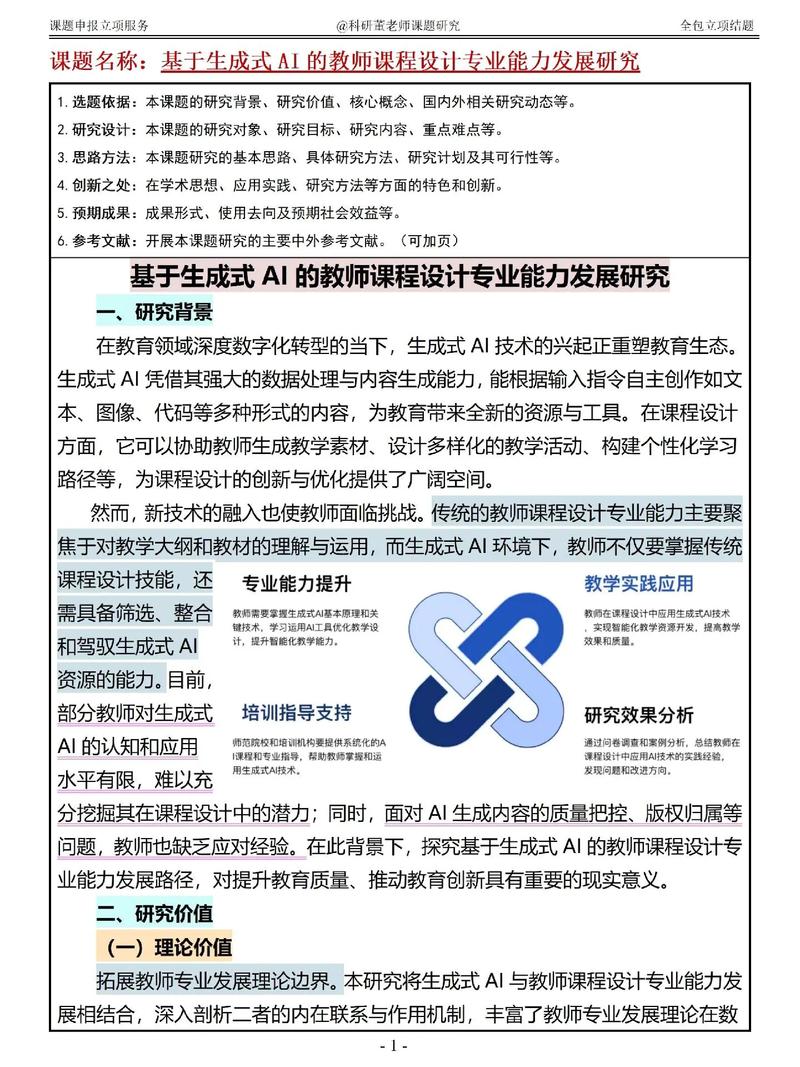

为了充分发挥AI的辅助作用,需要建立科学的伦理框架,建议学术界制定《AI学术工具使用白皮书》,明确AI在论文审查中的边界与责任,AI可负责事实核查、数据异常检测等机械性工作,而创新性判断、价值伦理评估仍需由人类专家完成。

在技术实现层面,开发者应注重算法的可解释性,当前最成功的AI审稿系统,其决策逻辑仍是一个"黑箱",这种不透明性可能引发新的学术信任危机,未来需要发展具有可解释性的审查算法,让学者清楚了解AI的质疑依据。

人机协同模式正在形成新的学术范式,某顶尖研究机构的实践表明,将AI系统作为"学术助理",帮助研究者优化研究设计、识别潜在漏洞,而非直接参与论文评审,能显著提升研究质量,这种角色定位或许才是AI与学术界的最佳相处之道。

站在技术浪潮之巅,我们需要清醒认识到:AI不是取代人类的学术裁判,而是拓展认知边界的智慧伙伴,当算法开始质疑论文的合理性时,这不仅是技术进步的标志,更是人类学术文明自我革新的契机,未来的学术生态,应是人类智慧与机器智能的交响,共同编织出更严谨、更开放的知识网络,在这场人机协作的思辨实验中,唯有保持理性与敬畏,才能避免技术异化为新的学术霸权。

AI论文-万字优质内容一键生成版权声明:以上内容作者已申请原创保护,未经允许不得转载,侵权必究!授权事宜、对本内容有异议或投诉,敬请联系网站管理员,我们将尽快回复您,谢谢合作!