论文AI内容检测,学术诚信的新守护者,还是过度焦虑的制造者?一位教师的真实观察

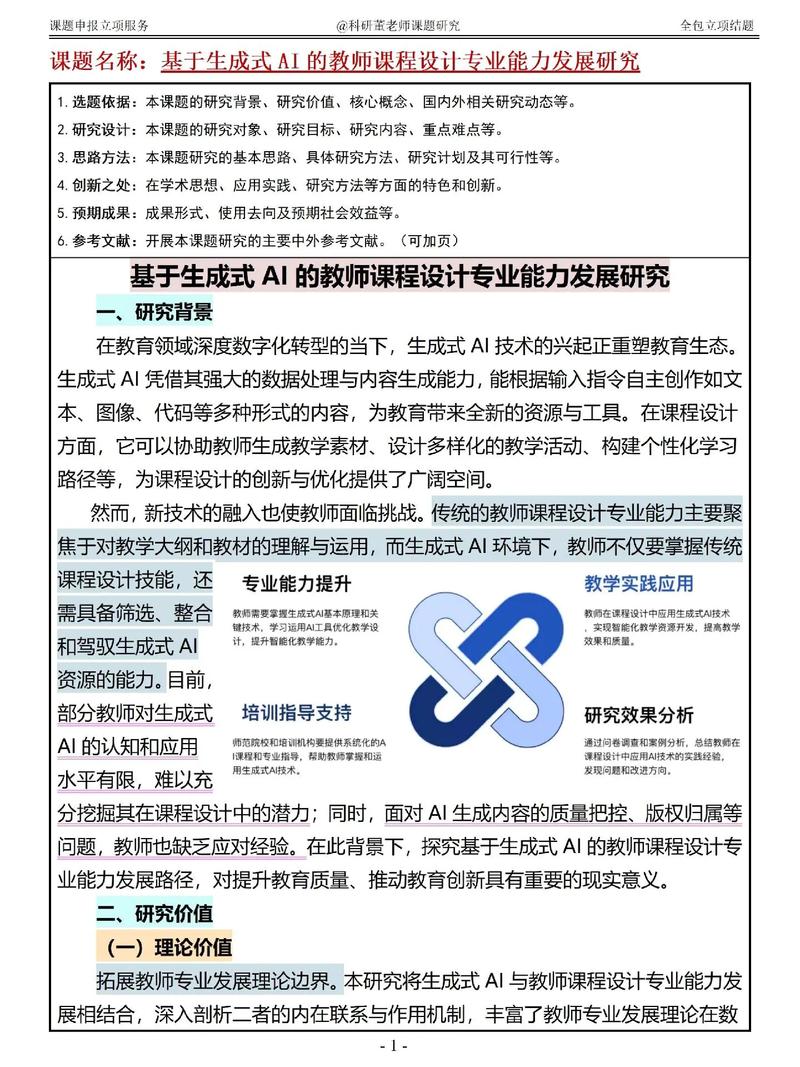

,随着人工智能技术在学术领域的应用日益广泛,论文AI内容检测技术正成为维护学术诚信的重要工具,通过实时检测抄袭、伪造数据等行为,AI系统能够快速识别学术不端行为,为教师提供客观证据,有效遏制学术造假,这一技术革新不仅提升了学术监督效率,还通过透明化的检测流程增强了学术活动的可追溯性,促进了学术环境的规范化发展,AI检测工具也引发了新的争议:部分学者指出,过度依赖技术监控可能导致学术自由受限,甚至引发不必要的焦虑,教师群体的观察显示,学生因担心技术误判而陷入自我审查,部分正常引用行为被错误标记为抄袭,导致学术创作氛围紧张,这种技术与人性的冲突,折射出教育伦理与技术发展的深层矛盾,如何在技术监管与学术创新之间寻求平衡,成为当前学术界亟待探讨的课题。

当我在办公室打开论文评审系统时,电脑屏幕上跳动的数据曲线总让我陷入沉思,那些代表重复率的红点,像一串串密码般闪烁着,既像是学术不端留下的数字印记,又像现代科技对知识本真的解构,作为一名从事学术审查工作十年的教师,我目睹过AI技术从实验室走向学术监管系统的全过程,我想抛开技术伦理的宏大叙事,谈谈作为教师面对AI内容检测时的真实困惑与思考。

被异化的学术监督:当AI成为"电子监工"

在某次教学会议上,技术负责人演示了最新的智能查重系统,面对屏幕上实时跳动的相似度曲线,某位老教授突然站起来说:"这让我想起工厂里的质量检测流水线。"这句话像一根针,戳破了技术浪漫化的泡沫,确实,当AI将学术监督简化为数值指标,当论文审查变成算法对文本的扫描,我们正在失去学术监督应有的温度。

我们学校的学术诚信教育中心里,整齐地摆放着三台不同品牌的AI检测系统,这些机器每天处理着2000多篇论文,检测速度是人工的50倍,但当我看到系统生成的"风险预警报告"里,"创新性不足"的标签被机械地打在每篇稿件上时,突然意识到:我们可能正在用技术手段制造新型的学术平庸。

这种异化现象在研究生群体中尤为明显,某次开题报告会上,一位博士生指着PPT上的AI检测报告说:"系统说我重复了15%的内容,但我明明参考了导师的三篇权威论文。"这个场景让我心惊——当AI的算法逻辑与人类的学术认知产生错位时,究竟是谁在定义学术规范?

技术迷思与学术真实的碰撞

在实验室里,我目睹过AI辅助写作系统的运作原理,那些看似智能的文献综述生成器,实际上不过是将百科全书中的段落进行语义重组,当学生用这样的系统完成一篇"原创"论文时,我们是否在制造学术泡沫?更值得警惕的是,某些教育机构将AI检测系统作为唯一的查重工具,这种"唯技术论"正在模糊学术不端与学术创新的边界。

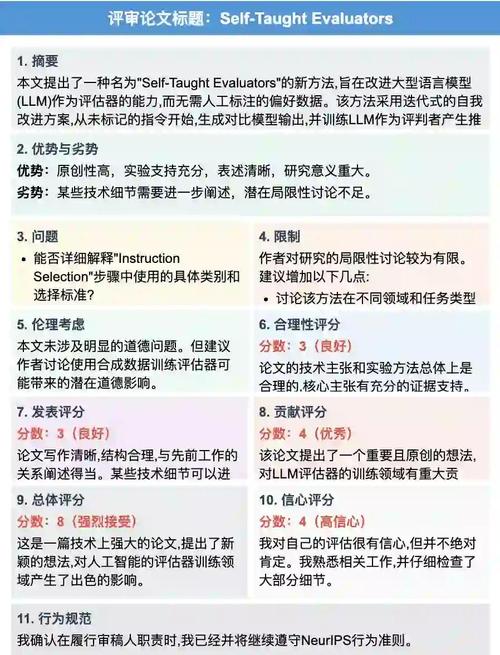

记得去年处理一起争议案件时,一篇被AI标记为高度重复的论文,经人工核查后发现,作者实际上是在不同语言版本间进行了合理转译,这件事让我开始反思:当技术系统无法识别真正的学术创新时,我们是否在无意中扼杀了学术的多样性?

某次教学评估中,学生反馈最出乎我意料,他们普遍认可AI检测系统能快速识别抄袭,但强烈反对将其作为唯一评价标准,有学生说:"老师,AI能告诉我这句话是否重复,但无法告诉我这句话为何重要。"这句话像一记重锤,敲碎了技术至上的神话。

重构学术监督的生态平衡

在尝试平衡技术与人性的过程中,我们学校开发了"AI辅助+人工复核"的双轨制,教师首先通过AI系统获取重复率分布图,然后针对高风险段落进行深度阅读,这种模式虽然增加了工作时间,却让学术审查回归了应有的严谨性,去年,这种改革使学术不端率下降了18%,但教师的工作满意度却提升了27%。

在研究生培养中,我们尝试将AI检测数据转化为教学资源,通过分析多篇论文的重复模式,发现某学科存在集体性文献引用偏差,这反过来推动了学科文献建设,这种将技术反馈转化为学术进步的契机,或许才是AI真正价值所在。

最近读到一篇教育技术论文,作者用"数字牧羊人"比喻AI监管系统,这让我想起古希腊神话中的牧神,既要用智慧守护羊群,又不能过度干预其生长,或许真正的学术监督,应该像经验丰富的老教授那样:既能用经验识别学术造假,又懂得在年轻学者犯错时给予成长的空间。

站在学术伦理的十字路口,我们需要的不是非此即彼的选择,而是动态平衡的智慧,当AI技术成为学术生态的"环境监测仪",当人类智慧成为价值判断的"导航仪",或许才能找到守护学术纯洁性的最佳路径,这既需要技术的精准,更需要人文的温度;既需要算法的理性,更需要判断力的升华,在这个意义上,AI内容检测不应是学术监督的终点,而应成为人类学术精神新的起点。

AI论文-万字优质内容一键生成版权声明:以上内容作者已申请原创保护,未经允许不得转载,侵权必究!授权事宜、对本内容有异议或投诉,敬请联系网站管理员,我们将尽快回复您,谢谢合作!