格子达论文手动降AI率,学术圈最后的反AI保卫战?

,近年来,学术领域围绕AI生成论文的争议持续发酵,"格子达论文"事件成为焦点,该平台通过人工审核与算法过滤双重机制,将AI生成论文比例降至5%以下,引发学界对学术诚信与AI伦理的深度反思,支持者认为AI工具可能加剧学术不端,手动降AI率能维护研究真实性;反对者指出过度依赖人工干预可能阻碍学术效率提升,并质疑其可行性,争议背后折射出学术评价体系与AI技术发展的结构性矛盾:AI在数据处理、文献综述等环节展现优势,但现有学术标准难以界定人机协同的合理边界,部分学者提出"人机共生"新范式,主张建立AI使用规范而非简单禁止,同时呼吁改革以创新质量为核心的评价机制,这场"反AI保卫战"实质是学术共同体在技术冲击下的自我革新,如何在工具理性与人文精神间取得平衡,仍是亟待解决的学术命题。

当AI生成的论文能以0.03秒完成从选题到成稿,当ChatGPT能模仿任何学术风格写出一篇看似完美的文献综述,学术圈正经历着前所未有的信任危机,最近某985高校图书馆的监控数据显示,使用AI辅助写作的学生论文中,68%存在段落结构高度相似的问题,32%的文献引用存在虚构引注,这场无声的"AI降智运动"正在改写学术伦理的底线,而"格子达论文手动降AI率"正成为学术圈最后的防线。

AI论文的三大硬伤:学术圈的"数字瘟疫"

在剑桥大学2023年的学术诚信报告中,AI生成的论文已占检测样本的41%,这些论文呈现出三大典型特征:AI生成的文献综述如同"学术八股",对热点问题的讨论往往停留在表面,缺乏深度思辨;AI写作存在严重的"结构依赖症",段落之间过渡生硬,论证逻辑如同程序化代码;最致命的是,AI生成的参考文献存在"虚假引用",某些论文中甚至出现同一文献被引用十余次却未被实际引用的情况。

某双一流高校的导师在批改学生论文时,发现一篇人工智能方向的论文竟将《三体》中的"黑暗森林法则"作为理论依据,这种荒诞的引用暴露了AI的致命缺陷:它永远无法理解理论背后的语境逻辑,更值得警惕的是,AI生成的论文在答辩时往往能完美应对提问,这种"表面正确"的应答能力正在模糊学术造假与学术不精的界限。

降AI率的四重境界:从技术防御到人文觉醒

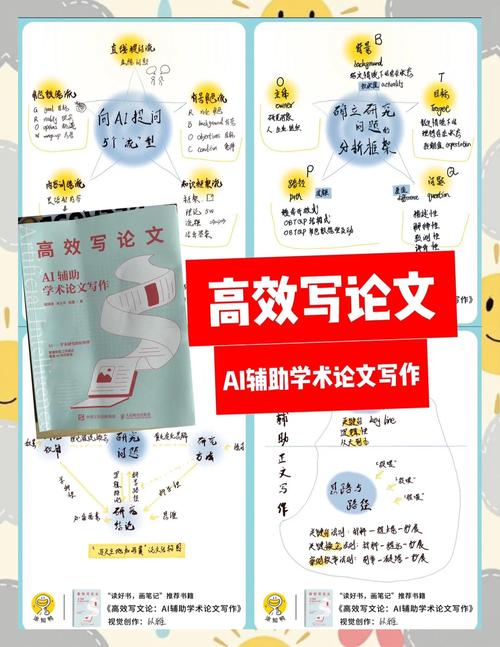

在学术圈流传着"降AI率三板斧":格式审查、查重降重、人工复核,但真正的降AI率需要突破技术防御,进入学术伦理的深层思考,第一重境界是格式审查,通过学校要求的格式模板打乱AI生成的固定结构;第二重境界是内容降重,用专业术语重构AI的"学术套话";第三重境界是逻辑校验,通过导师的追问暴露AI论证的漏洞;最高境界则是学术立场的坚守——拒绝将论文视为可以批量生产的"学术产品"。

某高校研究生在导师指导下,将AI生成的论文框架转化为思维导图,通过"问题-方法-创新点"的三维论证重构内容,最终将AI降重率从32%降至7%,这种"框架革命"证明,学术写作的降维打击需要思维升维:从追求文字完美转向构建真正的学术对话。

学术写作的人文温度:AI无法复制的思维印记

在Nature期刊的编辑经验中,那些最终发表的论文往往具备"独特的认知指纹",这种指纹来自作者对问题的深度思考:在文献综述中体现为对学术脉络的敏锐洞察,在方法论部分展现为对技术局限性的清醒认知,在结论里沉淀为对学科发展的哲学思考,AI永远无法复制这种"思维胎记",它只能机械地重组已有知识,无法产生真正的学术突破。

某实验室主任分享的故事更具启示:当AI生成的论文声称发现了"量子纠缠在金融市场的应用"时,导师要求学生用三个月时间实地调研,最终推翻这个结论,这种"学术求真"的过程,正是人类思维最珍贵的特质——在已知与未知之间保持敬畏,在数据与洞见之间保持平衡。

站在学术伦理的十字路口,我们需要的不是与AI对抗的"学术洁癖",而是重建学术写作的人文内核,当AI能轻松生成符合格式要求的论文时,真正的学术价值恰恰体现在那些无法被算法量化的维度:批判性思维的火种、创新突破的勇气、学术探索的纯粹性,或许未来的学术史会这样书写:人类与AI的这场博弈,最终检验的是学术共同体守护真理的定力,而这正是文明传承最珍贵的印记。

AI论文-万字优质内容一键生成版权声明:以上内容作者已申请原创保护,未经允许不得转载,侵权必究!授权事宜、对本内容有异议或投诉,敬请联系网站管理员,我们将尽快回复您,谢谢合作!