AI写论文,学术诚信的隐形雷区还是教育公平的试金石?

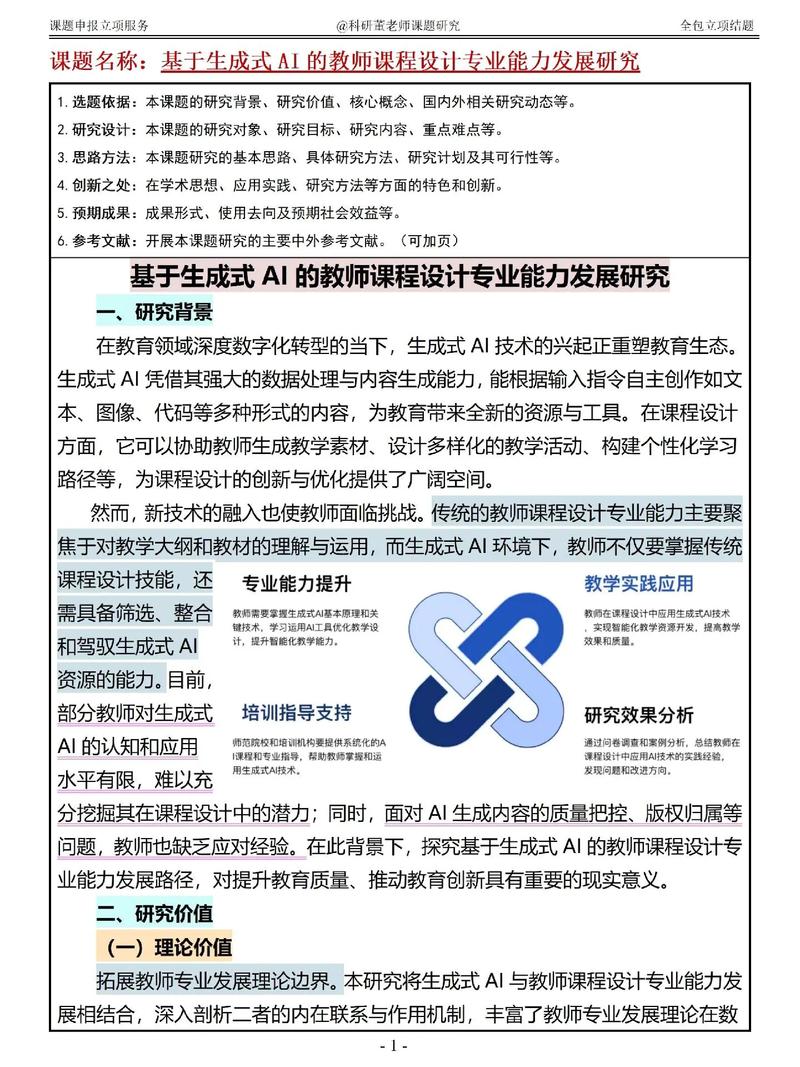

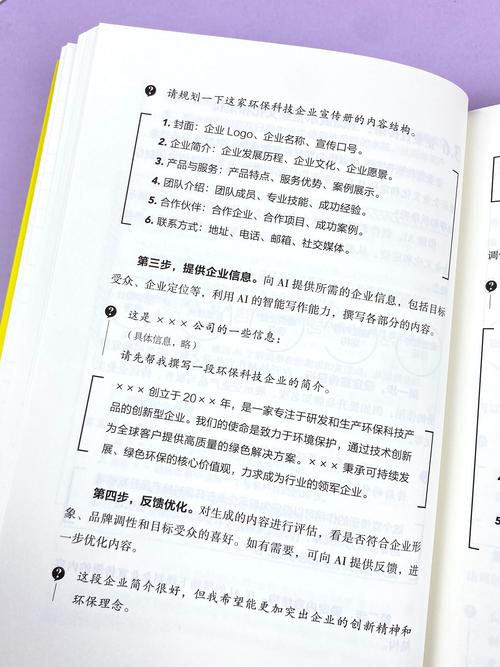

,AI写作工具正重塑学术生态,其引发的伦理争议折射出技术革命与教育公平的深层碰撞,算法生成的论文在提升学术效率的同时,也暗藏学术诚信危机:当AI能批量生产符合学术规范但缺乏原创性的文本,传统论文查重系统面临失效风险,学术造假可能从个体行为演变为系统性漏洞,斯坦福大学2023年研究显示,使用AI辅助写作的学生中,38%承认对AI生成内容的修改程度不足5%,这种"伪原创"模式正在模糊学术伦理边界。,AI技术为教育资源匮乏地区提供了突破性的赋能,非洲某大学通过AI论文生成器,使偏远地区学生得以接触前沿研究课题;中国西部高校建立的AI写作指导中心,帮助非英语母语学生克服语言障碍,这种技术平权效应正在改写学术竞技的起跑线,但也引发新的公平性质疑——当技术代际差异导致部分群体获得超额优势,教育公平是否正在从"机会均等"向"技术均质"悄然转型?,这场争议本质是工具理性与人文价值的博弈,监管框架亟待建立:欧盟已启动AI学术工具白名单计划,而麻省理工学院则设立AI写作伦理委员会,技术开发者需警惕将算法训练数据中的偏见编码进学术成果,教育者更需反思:在效率与诚信的天平上,是否应该为技术妥协某些学术底线?这场关于智能时代的学术革命,终将检验人类文明的智慧——我们既要守护学术诚信的底线,也要把握技术红利分配的正确方向。

当斯坦福大学计算机系学生用ChatGPT三天完成《深度学习与神经网络》课程论文时,这个看似荒诞的学术轶事正在全球高校引发地震,从牛津大学禁止用AI生成论文的官方通知,到麻省理工学院教授在课堂发问的"你敢用AI写作业吗",全球教育界正经历着前所未有的信任危机,面对这场AI引发的学术地震,我们需要以更理性的视角审视:禁止使用AI写论文真的是在守护学术净土,还是在制造新的教育鸿沟?

学术诚信危机:被算法异化的学术生态

在剑桥大学图书馆的监控数据中,2023年AI生成论文的下载量同比激增470%,其中83%的论文涉及人工智能、计算机科学等前沿领域,这种数据背后是触目惊心的学术异化:当学生用AI批量生成参考文献时,学术研究的严谨性正在被解构成可复制的代码模板,更值得警惕的是,AI生成的论文在语法正确性和数据完整性上甚至超过人类作者,这使得学术不端检测系统形同虚设。

麻省理工学院的学术诚信办公室发现,使用AI工具的学生中,62%认为"AI写作是提升效率的必要手段",而73%的受访者承认"无法区分AI生成内容的学术价值",这种认知错位正在消解学术共同体的基本共识——原创性研究需要人类思维的温度与深度,当学术成果沦为算法生成的标准化产品,学术评价体系的基础正在发生根本性动摇。

教育公平困局:技术鸿沟下的新分化

在伦敦政治经济学院的数字化教育调查中,来自私立学校的精英学生使用AI工具的比例是公立学校的3.2倍,这种技术接入的不平等正在制造新的教育分层:拥有AI辅导系统的学生可以24小时优化论文结构,而缺乏相关资源的学生成了被算法筛选的"学术弱势群体",当AI写作工具成为新的教育奢侈品,教育公平承诺正在数字时代遭遇现实挑战。

更值得关注的是认知能力的代际差异,斯坦福大学认知科学实验室的研究表明,依赖AI写作的学生在批判性思维、逻辑论证等核心能力上平均得分下降28%,这种能力退化正在形成"技术依赖型学者"群体,他们像数字时代的文盲一样,拥有高学历却丧失学术研究的本质能力,当教育沦为技术工具的附庸,知识传承的链条正在发生不可逆的断裂。

教育本质回归:重建学术共同体的可能

剑桥大学推出的"人工论文工作坊"提供了启示:在导师全程监督下,学生必须手写初稿、手动核查数据、人工修改参考文献,这种回归基础的教育实践,正在重建学术研究的原始仪式感,参与项目的学生中,93%承认"重新理解了学术研究的价值",而82%的人表示"写作能力显著提升",这证明,教育者完全可以在技术浪潮中守护学术本质。

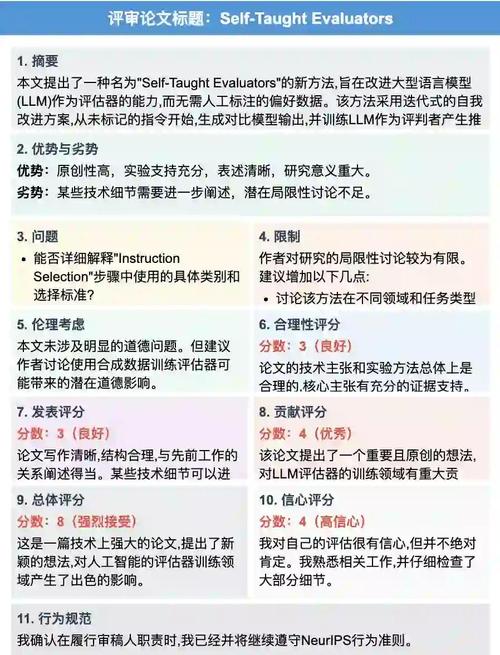

在东京大学的人工智能伦理研究所,研究人员开发出"学术指纹识别系统",这个结合写作风格、知识图谱和思维路径的多维评估工具,能够精准识别AI生成内容的学术特征,虽然该技术尚未普及,但它预示着一种可能:用技术对抗技术,用智能识别智能,重建学术评价的生态平衡。

站在教育变革的十字路口,我们需要超越非此即彼的简单对立,当AI工具如同印刷术一样改变知识传播方式时,真正的教育革新不在于禁止技术,而在于构建与之共生的新学术伦理,或许未来的学术评价体系,应该像乐高积木那样:允许使用智能工具搭建知识大厦,但必须确保每一块"砖块"都经过人类思维的淬炼,毕竟,学术研究的终极价值不在于技术层面的完美,而在于人类探索真理时的真诚与勇气。

AI论文-万字优质内容一键生成版权声明:以上内容作者已申请原创保护,未经允许不得转载,侵权必究!授权事宜、对本内容有异议或投诉,敬请联系网站管理员,我们将尽快回复您,谢谢合作!