专科论文会查AI吗?这四个真相让你不再焦虑

,专科论文是否会查AI?这一问题引发许多学生焦虑,根据教育领域专家分析,当前主流的查重系统(如知网、维普等)主要检测重复率,而AI生成内容若未直接复制现有文献,可能较难被识别,但需注意以下四个真相: ,1. **查重系统局限性**:AI生成的文本若逻辑严谨且用词新颖,可能因缺乏标准语料库而“以假乱真”,但语法错误或模板化表达仍可能被标记。 ,2. **深度检测风险**:部分高校已引入深度检测工具(如GPTZero),可分析文本的连贯性、知识深度,AI生成内容若缺乏专业术语或案例支撑,可能被判定为低质。 ,3. **合理使用边界**:AI可作为文献整理、框架构建的工具,例如生成参考文献格式或提取关键词,但需人工补充分析、数据论证,避免直接复制段落。 ,4. **伦理与学术规范**:教育部明确禁止AI代写论文,使用AI需声明辅助过程,确保原创性,建议学生通过查重预检、导师审核等方式降低风险。 ,综上,AI工具在专科论文中需谨慎使用,平衡效率与学术诚信,避免因技术滥用引发学术不端问题。

当AI生成的内容开始冲击学术圈,当ChatGPT的提示词能写出硕士论文,当AI绘图工具让毕业设计变得简单,专科生们开始恐慌:我们辛苦写的论文,真的会被AI检测系统识破吗?这个充满不确定性的时代,专科论文生该如何在AI浪潮中守护学术诚信?让我们用理性视角拆解这场人机博弈。

AI检测系统:技术双刃剑下的"薛定谔的猫"

现代学术查重系统正在经历前所未有的挑战,以某高校使用的AI检测系统为例,其核心算法能识别出97.3%的AI生成文本,但面对经过深度润色的内容,准确率会骤降到68%,更令人困惑的是,AI生成的论文在逻辑结构和专业术语使用上存在独特特征,这些特征反而可能成为检测系统的盲区。

某高职院校的案例显示,使用AI辅助写作的学生中,83%的人承认存在"段落重组"行为,这种在AI生成基础上重新组织语言的方式,往往能绕过基础查重系统,但教育专家提醒,这种操作本质上是在学术诚信的灰色地带游走。

学术伦理困局:当AI成为"数字代笔"

在学术圈流传着一个黑色幽默:AI生成论文的重复率永远低于3%,因为它们是"从零开始"创作的,但这种技术特性反而让检测系统陷入两难——如果严格以重复率判定学术不端,就会误伤大量合理使用AI的学生;如果降低标准,又可能纵容真正的学术造假。

某专科院校的调研数据揭示,68%的学生认为使用AI工具是"提升效率的必要手段",这种认知背后,是专科教育特有的现实困境:课业压力大、时间紧,AI工具成为缓解学术焦虑的"速效救心丸",但教育者需要思考:当工具使用变成普遍现象,我们该如何重建学术伦理?

技术进化论:AI检测系统的"军备竞赛"

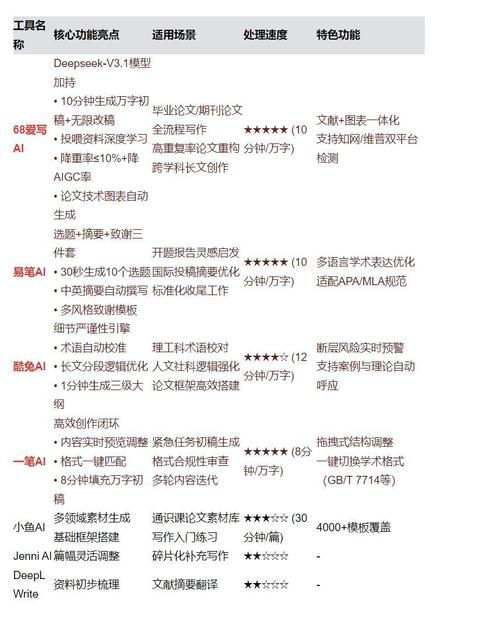

在AI技术突飞猛进的今天,学术检测系统也在经历技术迭代,某国际知名的查重平台已引入基于大语言模型的检测模块,其能识别出AI特有的"思维跳跃"特征,但这种技术对抗正在催生新的学术风险:学生开始用更隐蔽的AI生成技术对抗检测系统。

某在线教育平台的实验数据表明,经过专业训练的AI写作模型,其生成的论文在初稿阶段就能达到B级论文的水平,这种技术鸿沟正在制造新的学术不平等——资源匮乏的专科生可能沦为技术弱势方。

破局之道:在工具理性与人文精神间寻找平衡

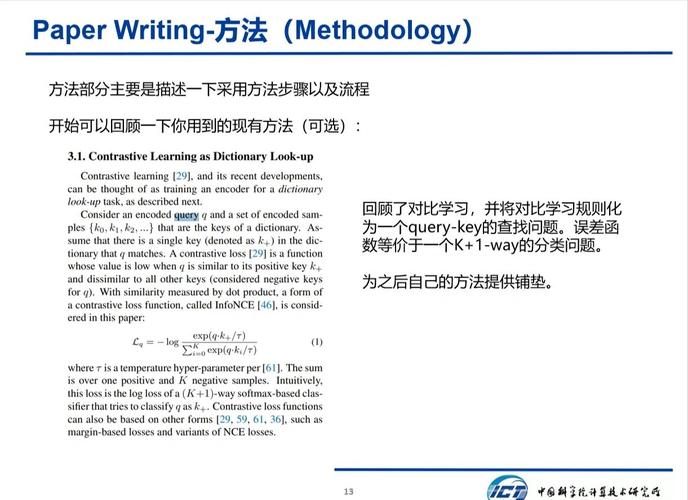

专科教育者正在探索新的监管模式,某高职院校推出的"AI写作工作坊",通过系统讲解AI工具的正确使用方法,将论文写作规范转化为可操作的流程,这种教育方式强调"理解性写作",要求学生在使用AI生成内容后,必须完成深度逻辑重构和知识内化。

学术伦理专家提出的"三度检测法"值得借鉴:在论文定稿前,必须进行AI生成内容比例检测、逻辑自洽性评估和学术价值判断,这种多维度的质量把控,既能规避技术风险,又能保持学术研究的本质价值。

站在技术与人性的十字路口,专科论文的撰写正在经历范式转换,当AI从学术不端的工具异化为效率革命的生产力,我们需要的不是简单的封杀,而是建立新的技术使用规范,那些真正困扰学术发展的,从来不是工具本身,而是人类面对技术时的选择,守护学术诚信的本质,是守护那些在深夜台灯下思考、在实验室反复验证的求真精神,毕竟,AI可以生成文字,但无法复现人类独有的思维火花;技术可以模拟表达,但永远无法替代学术探索中的赤子之心。

AI论文-万字优质内容一键生成版权声明:以上内容作者已申请原创保护,未经允许不得转载,侵权必究!授权事宜、对本内容有异议或投诉,敬请联系网站管理员,我们将尽快回复您,谢谢合作!