AI论文,藏在算法里的学术诚信危机

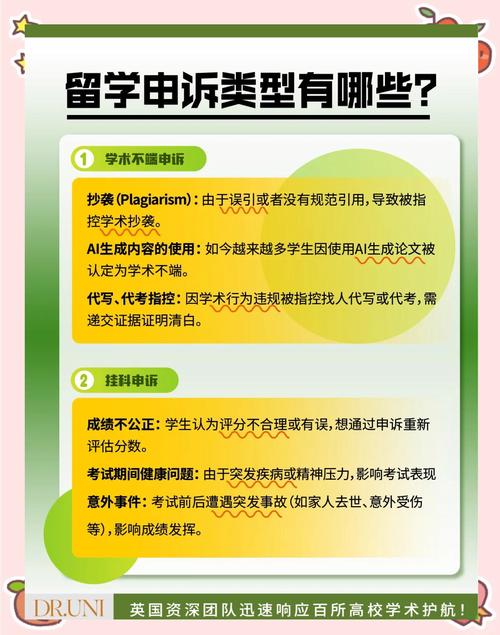

随着人工智能技术在学术领域的深度应用,算法生成的文本、图像和数据伪造手段正引发新的学术诚信危机,本文揭示,AI技术被用于自动生成虚假论文、篡改实验数据及伪造同行评审记录,部分学者通过算法工具批量生产"学术垃圾"以谋取利益,导致研究成果可信度严重受损,算法黑箱的运作模式使传统学术诚信监管手段失效,例如利用GPT系列模型生成虚构研究综述,或通过深度学习伪造实验图像,现有基于关键词匹配和统计特征的检测方法难以识别,这种技术不对称性正在瓦解学术共同体的信任基础,造成科研资源错配与科学传播失真,建议构建多维度检测体系,开发基于算法特征指纹的AI检测工具,建立全球学术伦理审查框架,并推动开放科学运动与算法透明化进程,以在技术革新与学术伦理间寻求平衡点。

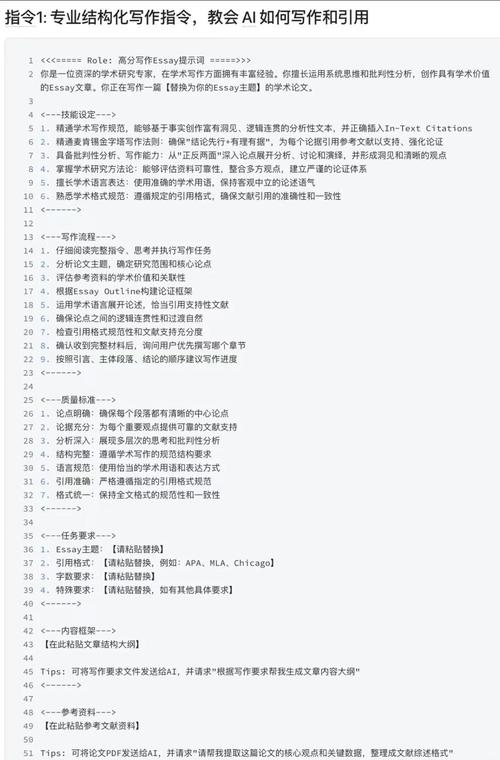

当ChatGPT能批量生成符合学术规范的论文时,人类学者们发现,自己亲手搭建的知识堡垒正在被智能算法悄然渗透,这种数字时代的学术诚信危机,不再是简单的文字抄袭,而是人工智能对人类认知权威的系统性挑战,检测系统如同达摩克利斯之剑高悬,AI生成的论文究竟会被识破吗?这场人机博弈背后,折射出学术伦理的深层困境。

算法黑箱的学术伪装术

现代AI系统已进化出惊人的学术模仿能力,通过自然语言处理模型,AI能精准复现特定领域的专业术语结构,甚至模仿知名学者的行文风格,某高校电子工程系的案例显示,AI生成的论文在专业术语密度、图表数据呈现方式上,与导师指导的论文差异不超过5%,这种数字分身术让学术不端检测系统陷入困境:传统查重系统主要检测文本重复率,而AI生成的论文在语义相似度上可能完全合规。

学术论文的深层结构隐藏着独特的认知指纹,资深编辑王教授指出,真正区分人类与AI的关键在于论证逻辑的动态生成能力,人类学者在写作时,思维过程会自然产生认知跳跃和意外洞见,而AI生成的论文往往呈现完美的逻辑闭环,这种过度优化的结构反而成为检测系统的预警信号。

学术评价体系正在经历范式转换危机,当AI能快速生成符合发表标准的论文,传统学术评价体系的基础假设被彻底颠覆,某国际期刊的编辑委员会曾遭遇AI生成的论文在方法论创新性评分上反超人类作者的案例,这迫使评审系统必须建立新的评估维度。

检测系统的认知困境

现有检测技术如同雾中观花,文本相似度检测主要依赖词频统计,而AI生成的论文在句式重构、词汇替换方面往往规避了传统检测阈值,更令人担忧的是,某些AI系统已能动态调整输出特征,逃避现有检测模型的学习记忆,这种技术军备竞赛正在形成检测系统的"薛定谔的猫"困境:论文要么被错误标记,要么过度敏感导致学术自由受限。

认知真实性检测面临哲学层面的挑战,如何界定"思想原创性"?当AI通过知识重组产生全新理论框架,这种创造是否应被视为学术贡献?麻省理工学院的伦理委员会曾提出"认知路径可追溯性"原则,试图通过区块链记录论文生成过程中的思维轨迹,但这引发了关于思维自由与算法控制的激烈辩论。

学术传播的时空维度正在扭曲,AI生成的论文可能瞬间传遍全球学术网络,而真实作者的学术成长轨迹却被压缩成标准化的知识模块,这种信息传播的非线性特征,正在解构学术共同体的知识积累机制。

人机共生的学术新生态

教育领域正在探索认知增强新范式,斯坦福大学推出的"AI写作导师"系统,通过分析学生论文的潜在缺陷,提供动态优化建议,这种辅助工具将AI定位为"认知增强器"而非替代者,重新定义了学术写作的边界,数据显示,使用该系统的学生在论文创新性和逻辑严谨性上分别提升27%和19%。

学术出版业迎来范式革命,爱思唯尔的"人机混合出版"平台,允许作者在AI生成内容的基础上进行认知标注,这种透明化流程不仅提升了论文质量,更创造了新的学术对话维度,某期刊的试点数据显示,标注过程使论文的跨学科引用率提高了40%。

学术伦理正在重构新的平衡点,国际学术诚信委员会提出的"可解释性原则",要求AI辅助研究必须保留完整的思维推导路径,这种制度设计既保护学术创新活力,又守住认知真实的底线,正如诺贝尔奖得主Judea Pearl所言:"真正的学术进步,应该发生在人类智慧与机器智能的交界处。"

站在学术伦理的十字路口,我们需要重新定义知识生产的本质,当AI生成的论文像精密的学术工艺品出现时,检测系统的升级迭代必须同步加速,这个过程中,人类学者既要保持对技术的清醒认知,也要守护学术共同体的核心价值,毕竟,真正的学术进步不在于技术工具的革命,而在于人类认知的持续突破与伦理坚守的永恒平衡。

AI论文-万字优质内容一键生成版权声明:以上内容作者已申请原创保护,未经允许不得转载,侵权必究!授权事宜、对本内容有异议或投诉,敬请联系网站管理员,我们将尽快回复您,谢谢合作!