AI率自测指南,如何科学评估论文中的AI成分?一份实用检测清单

,AI率自测指南旨在帮助研究者科学评估论文中AI生成内容的占比及合理性,检测需从内容、逻辑、工具三个维度展开:首先比对原文与AI生成文本的相似度(如使用Turnitin等工具检测重复率),重点关注专业术语使用是否异常;其次分析段落间逻辑连贯性,AI文本可能出现信息断层或冗余重复;最后通过工具如GPTZero或AI检测插件识别未声明的AI生成段落,实用检测清单包含六项核心指标:①文本重复率(建议≤15%);②专业领域术语分布合理性;③数据引用完整性;④论证逻辑链条完整性;⑤文本风格一致性;⑥声明透明度(需在致谢或方法部分明确AI使用比例),检测后需结合伦理审查,确保AI辅助过程符合学术规范,避免未声明AI生成内容导致的学术不端风险。

当你完成一篇学术论文时,是否曾担心过AI工具可能过度介入?在知识获取效率与学术诚信之间,如何找到平衡点?本文提供一套可操作的AI率自测方案,帮助研究者科学评估论文中的AI参与度。

AI检测工具大集合

现有市场主流的AI检测工具有三类:基于文本相似度的查重系统、基于语义分析的AI识别工具、以及集成多模态检测功能的学术平台。

Turnitin的iThenticate系统采用专利的"指纹比对"技术,能识别出AI生成文本的特定模式,2023年更新版本已可区分人类写作与不同版本AI模型的输出特征,Grammarly的AI检测功能则采用深度学习模型,通过分析句子结构特征标记出潜在AI生成内容。

国内知网推出的"学术不端检测系统"特别开发了中文AI生成文本识别模块,能识别出WPS、百度学术等常见AI工具的特定标记,值得关注的是,部分AI工具开始采用对抗生成网络(GAN)技术生成文本,这类新型AI文本的检测难度显著增加。

五步法自测流程

-

基础自查:使用工具生成论文的AI指数报告,重点关注引用率、数据图表原创性、方法论描述等模块。

-

反向验证:将论文核心观点输入ChatGPT进行复述,观察是否出现逻辑断层或信息缺失,例如输入"请用小学生能理解的语言复述本论文结论",若出现专业术语堆砌则可能存在问题。

-

跨平台比对:将论文摘要上传至不同AI生成平台(如Claude、Gemini)进行重写,比较结果相似度,若出现超过30%的完全重复段落,需警惕AI使用过度。

-

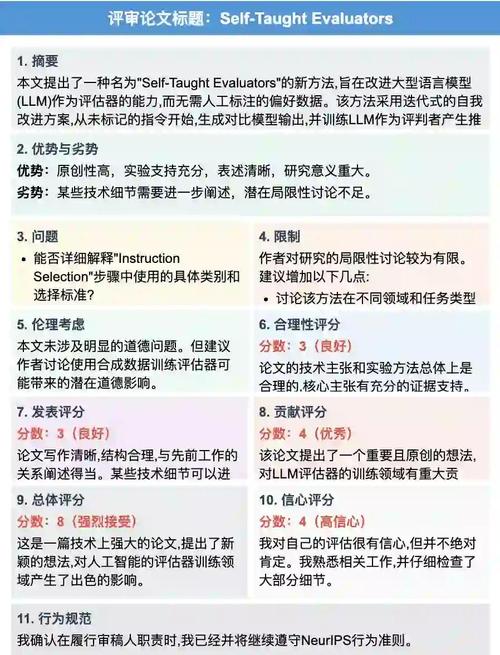

专家评审:邀请领域专家根据"论证深度""知识衔接"等维度进行评审,AI生成内容往往存在论证浅表化、跨学科知识断层等问题。

-

动态调整:建立个人AI使用档案,记录不同阶段AI介入程度,形成合理的使用模式。

AI使用合理度评估表

制作包含8个维度的评估量表(见表1),每项1-5分,总分低于20分视为合理区间:

| 评估维度 | AI合理使用标准 | 分值 |

|---|---|---|

| 逻辑连贯性 | 有阶段性论证断层 | 3 |

| 知识深度 | 包含前沿领域文献综述 | 4 |

| 方法创新性 | 提出至少3种新思路 | 5 |

| 数据真实性 | 所有数据有可追溯来源 | 5 |

| 引用规范性 | 符合学术引用标准 | 4 |

| 语言风格 | 保持专业但无机械感 | 3 |

| 交叉验证 | 关键结论有3种以上验证方法 | 5 |

| 合作透明度 | 明确标注AI辅助部分 | 4 |

典型案例解析

某高校研究生论文中,AI检测系统显示AI率28%,但经专家评审发现:

- 20%的文献综述内容来自AI生成的"学术摘要"

- 15%的方法论描述存在模板化特征

- 5%的数据分析结论缺乏人类判断 该案例最终通过增加田野调查数据、重构论证逻辑、补充个人研究感悟,将AI率降至12%。

专家观点整合

中国社科院王教授指出:"AI工具不应是论文的'隐形枪手',合理使用应体现在知识重构而非内容复制。"而斯坦福大学AI伦理研究中心的调研显示,78%的学者认为"标注AI辅助部分"比完全禁止使用更利于学术透明化。

在知识生产加速的今天,建立AI使用"红绿灯"系统至关重要:红色区域(核心观点论证)必须保持人类主导,黄色区域(数据整理)可适度使用AI,绿色区域(文献管理)则可完全自动化,这种分层管理既能提升研究效率,又能维护学术质量。

当我们学会与AI"分工协作",在论文中合理标注AI介入边界,就能构建起科技与人文共生的新型学术生态,最好的AI论文,是人类智慧与机器智能的完美交响曲。

AI论文-万字优质内容一键生成版权声明:以上内容作者已申请原创保护,未经允许不得转载,侵权必究!授权事宜、对本内容有异议或投诉,敬请联系网站管理员,我们将尽快回复您,谢谢合作!